«Понять — значит упростить» — лаконично и точно сформулировали братья Стругацкие в повести “Волны гасят ветер”. Испокон века наука делала именно так.

Ньютон упростил свои законы до одной универсальной идеи — гравитации, объясняющей движения любых тел: от падающих яблок до планет, от полета камня из пращи до пули и ракеты.

Но законы Ньютона, как и вся наука, построенная на их фундаменте, имели пределы. Они не смогли справиться с очень сильной гравитацией, чрезвычайно быстрым движением и сверхмалыми частицами.

Теория относительности и квантовая механика смогли превзойти эти ограничения, по-своему упростив макро и микро-мир парой оригинальных и интригующих идей.

- Гравитация — это искажение пространства-времени массивными телами.

- Свет и элементы, составляющие материю, могут вести себя не только, как частицы, но и как волны.

Но и после триумфа теории относительности и квантовой физика, все равно оставалась область, где наука тщетно пыталась найти способ упростить особый класс систем, не поддававшихся упрощению.

Самое неприятное было в том, что этот неупрощаемый класс т.н. сложных систем встречается буквально повсюду и описывает важнейшие системы мироздания.

- Некоторые из таких систем физические — например, электросети или Интернет.

- Многие из них биологические — мозг, органы, экосистемы.

- Третьи — самый непонятный для упрощения подкласс — социальные системы общества, финансовые рынки, системы корпоративного управления и, конечно же, наше все 21го века — социальные сети.

И вот, наконец, к концу 2ой декады 21 века свершилось, — смогли упростить и их.

Сознан формализм, позволяющий математически (количественно) описать принципиальное отличие сложных систем от всех остальных классов систем — их структурные свойства, как совокупность отношений между всеми наборами компонентов в системе.

Теперь, упростив и создав математический формализм, шансы понять, как же работают все эти важнейшие из систем окружающего мира, включая нас самих, становятся реальными.

О новой интригующей работе Института комплексных систем Новой Англии (NECSI), формально открывающей путь к пониманию поведения (зависящего от структурных свойств) сложных систем (от соцсетей до государств) — будет рассказано в этом посте.

Как измерить сложность

Четыре года назад исследователи NECSI придумали и математически описали принципиально новый способ количественного определения структуры и сложности систем.

«Системы из разных областей и контекстов могут иметь общие структурные свойства, заставляющие их вести себя одинаково»,

– писали Бенджамин Аллен, Блейк Стейси и Янир Бар-Ям в своей довольно революционной работе An Information-Theoretic Formalism for Multiscale Structure in Complex Systems.

По мнению авторов, эти структурные свойства зависят от того, как части системы соединены вместе, и как одни части влияют на действия других.

Здесь, для не особо искушенных читателей, стоит дать хотя бы небольшое пояснение. Иначе весь последующий текст (и так не самый простой) может для них превратиться в ребус. Умудренные читатели, знакомые с темой нижеследующего пояснения, его просто пропустят.

>>> Пояснение: связь энтропии и структурных свойств информации.

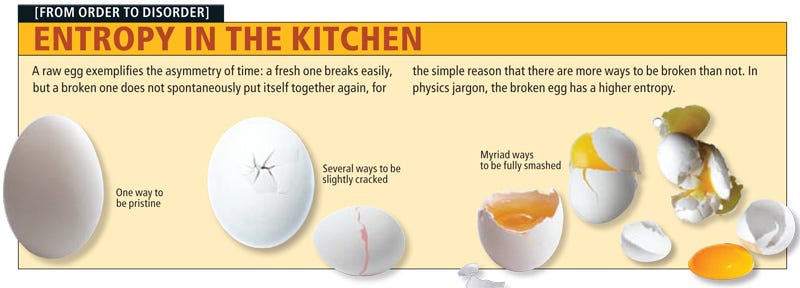

Спачала напомню, что энтропия —в широком смысле, означает меру неупорядоченности или хаотичности системы: чем меньше элементы системы подчинены порядку, тем выше энтропия.

Теперь о том, как энтропия связана с информацией.

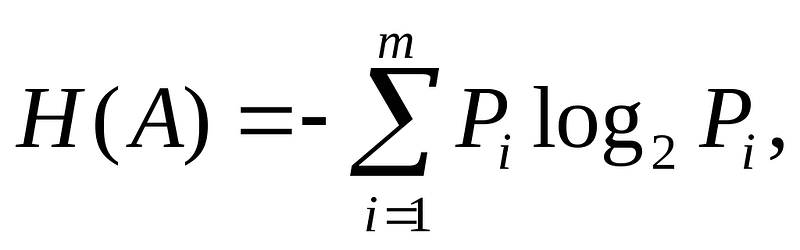

Шеннон предложил для этой связи используемую в статистической физике вероятностную функцию энтропии:

где Pi — это вероятность наступления i-го исхода события; где i в общем случае принимает значения: i = 1, 2, 3 … N, а в случае текста: i = а, б, в … я.

Т. е. получается, что энтропия напрямую связана с «неожиданностью» возникновения события.

А отсюда возникает понятие информативность — чем событие более предсказуемо, тем оно менее информативно (подробней см.,например, здесь).

Теперь допустим (далее следует пример и текст из работы Е.А. Седова, о которой будет специально рассказано ниже), что некто получил сообщение о том, что из яйца вылупился птенец.

Далее следуют уточнения, что это именно птенец, а не малек, потому что он дышит легкими, а не жабрами, имеет не плавники, а крылья и т. п. Разумеется, все это будет избыточной информацией для получателя, который знает, чем птенец отличается от малька.

Однако та же самая информация, заключенная в генетическом коде,

является именно той структурной информацией, которая определяет весь процесс эмбриогенетического формирования птенца.

Тогда оказывается справедливым, что избыточная информация равна структурной. Из чего следует, что структурная информация равна разнице между максимальной и реальной (наблюдаемой) энтропией (степенью неожиданности), и эта разница может служить количественной мерой упорядоченности текста или структуры любых систем.

Важно отметить, что при исчислении количества информации по

Шеннону игнорируется ее смысл и ее ценность. Так, например, для гражданина Белова одно и то же количество информации (I бит) содержится в таких двух различных по своей ценности сообщениях, как «Завтра не будет дождя» и «У вас родился сын».

Попытки введения количественных мер смысла и ценности информации показали, что эти меры не могут обладать такой же степенью универсальности, как мера, предложенная Шенноном, по той простой причине, что нельзя одними и теми же единицами измерить ценности закона Ома и признания в любви.

Абстрагируясь от смысла и ценности информации, Шеннон фактически поступил так же, как Галилей в свое время поступил с силой трения: исключение этих факторов из поля зрения позволило установить более общий закон.

Мера, найденная Шенноном, оказалась единой универсальной мерой упорядоченности для всех существующих в мире систем.

Однако эта мера, как и законы Ньютона, основываласб на серьёзном упрощении. И потому имела важное ограничение — она не годилась для любых масштабов.

>>> Конец Информации к размышлению.

Описание всех этих мер и отношений математически — ключ к царству сложности. Но тут-то и скрывалась проблема: сложные системы слишком сложны для обычных математических подходов.

«Можно ожидать, что набор компонентов системы для физических, биологических или социальных объектов реального мира будет настолько сложным, что для всех практических целей их точное описание, в конечном итоге, будет просто неподъемным»,

– писали авторы в своей работе.

«Достижение фундаментального решения этой проблемы имеет решающее значение для нашей способности расширить теоретическую физику, как общий подход к сложным системам, а практическое решение имеет решающее значение для нашей способности решать многие реальные проблемы».

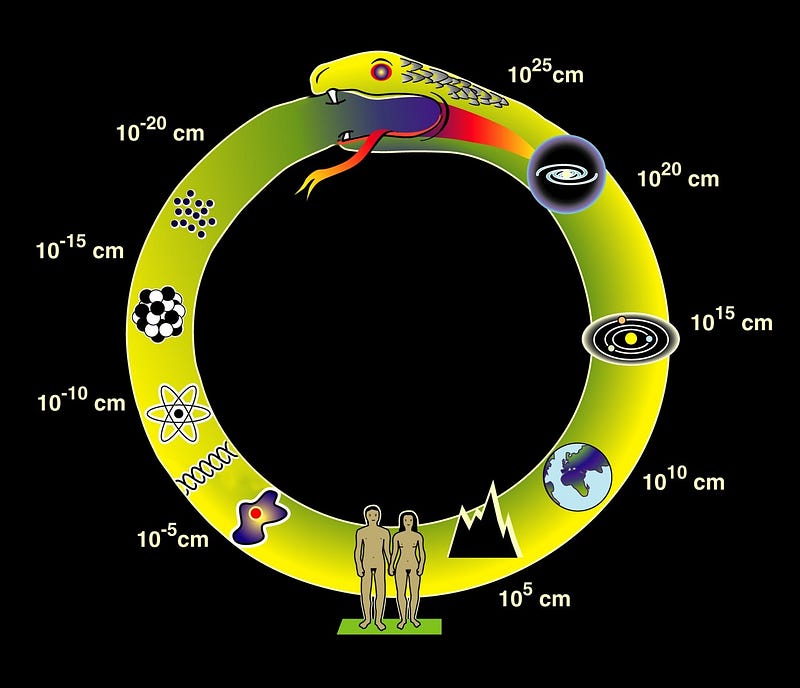

Главная же проблема, с которой здесь столкнулись ученые, была та же, что и для теории относительности и квантовой механики

— очень широкий диапазон масштаба систем.

Традиционные информационные меры игнорируют масштаб, в котором проявляется поведение систем. В то же время, системы демонстрируют различное поведение в разных масштабах. Только с учетом важности масштаба можно должным образом учесть структуру и сложность. Эффективный подход

«требует понимания теории информации в многомасштабном контексте, который не был развит ни в теории информации, ни в статистической физике фазовых переходов».

Авторы новой работы смогли решить эту мега-проблему следующим образом.

- Дано определение структуры как «совокупность отношений между всеми наборами компонентов в системе». Эти отношения определяют, относится ли информация об одной части системы к другим частям системы. Другими словами, структура отражает обмен информацией между частями системы. Обмен информацией означает, — то, что делает одна часть, зависит от того, что делает другая. И этот обмен определяет поведение систем при разных масштабах.

- Вводятся две меры для обобщения понятия структуры систем. Одна из них, называется профилем сложности (он высок для систем, состоящих в основном из независимых частей, и резко падает для сильно взаимозависимых систем). Другая мера называется предельной полезностью информации (она количественно определяет, насколько хорошо система может быть описана с помощью ограниченного объема информации). Вместе эти две меры позволяют избежать многих проблем и парадоксов, которые препятствовали предыдущим подходам к количественной оценке сложности и структуры.

В итоге, данная работа заложила основы нового понимания природы, отличного от простого ее разрезания на кусочки и изучения того, как эти кусочки работают изолированно.

Том Зигфрид так резюмировал результаты этой работы в журнале Sciencenews:

“Вполне возможно, что понимание того, как эти части образуют структуры путем обмена информацией в разных масштабах, действительно станет ключом к раскрытию тайн поведения сложных систем”

Новый прорыв — математическое доказательство парадоксальной неустойчивости беспорядка

Однако, одним ключём сейф сложных систем не открывался. Четыре года ушло у исследователей из NECSI на поиск второго ключа к решению задачи формализации сложных систем.

И вот только что опубликованная работа Таира Бар-Яма, Оуэна Лича и Янира Бар-Яма The Inherent Instability of Disordered Systems, на основе разработанных ранее количественных мер оценки сложности систем, описывает полный математический формализм развития процесса сложности для систем, находящихся в структурированных средах и имеющих произвольный масштаб.

В новой работе доказано —

любая неструктурированная система, вырастая выше определенного масштаба, не в состоянии противостоять структуре, большей этого масштаба.

Чтобы описать сложную внутреннюю динамику, авторы разработали характеристику многомасштабных изменений в системе. Эта характеристика основана на синтезе кибернетического закона Эшби (Закон необходимого разнообразия — The Law of Requisite Variety) и теоретико-информационных представлений Шеннона о шуме, и при этом учитывает фактор структурирования информации.

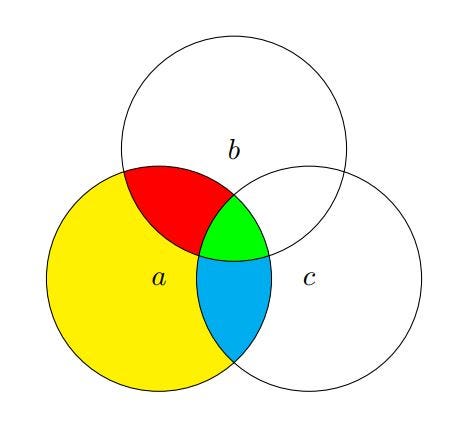

Этот рисунок — трёхмерная визуализация того, как на разных уровнях иерархии работает базовое понятие нового формализма — неприводимые зависимости (irreducible dependencies) между частями (элементами) сложных систем. В отсутствии иерархий (в двумерном варианте) это можно представить с помощью диаграммы Венна следующим образом.

красная (a; b|c), синяя (a; c|b), желтая (a|b; c). Суммируя всю разделяемую информацию для всех покрашенных областей, получаем полную энтропию переменной а. Все другие (приводимые) зависимости — это объединения неприводимых зависимостей. Например, желтая и синяя области комбинируют (a|b), синяя и зеленая вместе дают (a; c), и т.д..

Простота приведенных картинок пусть не ведет к заблуждению, что новый формализм описания сложности систем, на самом деле, не так уж и сложен.

Он весьма сложен и включает в себя 2 леммы и 4 теоремы, выглядящих в виде формул (в качестве примера) так:

Эта теорема показывает, как подсистема становится частью окружающей среды. Из этой теоремы следует, что уровень сложности шума и есть то, что является отличительным свойством отдельных подсистем.

Как тут не вспомнить

- мой любимый рассказ “Уровень шума” о беспредельных возможностях познания, достижимых, если мы научимся использовать максимальный уровень шума человеческого разума;

- а также о “новом законе Мура” для извлечения смыслов из зашумленных Больших данных, источником шума в которых является добавление узлов с неполной информацией о соединениях или непредсказуемых соединениях.

Полученный формализм, в качестве иллюстрации его универсальности, авторы переносят на политический анархизм, показывая, что в обществе спонтанно формируются процессы упорядочения с образованием вышестоящих уровней иерархий, даже при отсутствии традиционных высших иерархий типа правительства.

Выводы этой работы авторы также интерпретируют, как «Обратный 2ой закон термодинамики» —

в то время, как закрытые системы разрушаются до полного беспорядка, системы, открытые для структурированной среды, спонтанно создают порядок на все более высоких уровнях иерархии.

От науки о деградации к науке о самоорганизации

«В середине 20го века в науке произошла революция, последствия которой еще предстоит по достоинству оценить. Если до этого времени наука способна была объяснить только тенденциидеградации, определяемые 2м началом термодинамики (законом роста энтропии), то с 50-х годов, с развитием методов неравновесной термодинамики, теории информации, синергетики, начали выявляться механизмы взаимодействий, которые обусловливают самоорганизацию различных по своей природе систем.

В частности, в данной работе будет показано, что методы теории информации, разработанные К. Шенноном для чисто прикладных задач техники связи, оказываются универсальным средством анализа процессов самоорганизации как простейших физических тел, так и сложнейших интеллектуальных и социальных систем».

Это цитата из последней работы уже цитировавшегося выше выдающегося российского ученого Евгения Александровича Седова— автора закона иерархической компенсации (закона Седова).

Этот закон:

- охватывает живую и неживую природу, язык, культуру, все сферы социального управления;

- существенно дополняет классический закон необходимого разнообразияУ. Р. Эшби;

- представляет собой богатое следствиями открытие в области методологии;

- объясняет, — возрастает или, напротив, сокращается внутреннее разнообразие систем в процессе эволюции.

Согласно закону Седова (в его обобщенной форме, сформулированной А.П. Назаретяном),

рост разнообразия на верхнем уровне иерархической организации обеспечивается ограничением разнообразия на предыдущих уровнях, и наоборот — рост разнообразия на нижнем уровне разрушает верхний уровень организации. При этом функциональная унификация несущих структур увеличивает совокупное разнообразие системы.

Иными словами, как это формулировал А.Д Панов, — “«иерархические компенсации» — это когда появляется новый лидер эволюции, и старые развивающиеся системы не исчезают, а только меняют свое место в развивающейся системе, в некоторой степени перемещаются на ее периферию и, возможно, становятся несколько сокращенными”.

Закон Седова сопоставим по предмету и по охвату с законом необходимого разнообразия и составляет необходимое дополнение последнего.

В своей последней работе “Информационно-энтропийные свойства социальных систем” (написанной по выступлению на очередном заседании Междисциплинарного семинара по изучению

цивилизационных кризисов 28 января 1993 года, и законченной автором за 2 дня до смерти) Е.А. Седов успел разработать минимально необходимый для ее обоснования математический аппарат.

И потребовалась четверть века, чтобы был разработан полный формализм, позволяющий количественно оценивать меры сложности при эволюции сложных иерархических систем любых масштабов, — в том числе, и в соответствии с законом Седова.

Этот новый математический формализм, описанный в работе The Inherent Instability of Disordered Systems, по моему мнению, среди прочего, открывает великолепные перспективы, создания законченного формального описания закона иерархической компенсации.

Ну а это, в свою очередь, может стать поворотным моментом в упрощении понимания поведения физических, биологических и социальных систем не только на основе характеристик их составных частей, но и с учетом структуры их взаимодействий.

Возможно также, что этот формализм позволит, говоря словами А.П. Назаретяна (работавшего вместе с Е.А. Седовым над изучением вопросов в контексте закона иерархической компенсации) — «выявить соотношение разнообразностных характеристик в системах любого рода — от космофизических до когнитивных — и механизм изменения этого соотношения в процессе эволюции» (подробней см. в книге А.П. Назаретяна “Нелинейное будущее”).

Если же принять во внимание, что «закон Седова» также является одним из предопределяющих факторов фазовых переходов в процессе общей сингулярности эволюции, то его полная формализация в виде обратного 2го закона термодинамики может оказаться весьма полезной для перехода от качественных к количественным оценкам.

В зону сингулярности (1я половина или 2/3 21 века) человечество уже вошло. А поскольку, как считает А.Д. Панов,

“зона сингулярности — это практически концентрация кризисов, и мы будем ощущать это время сингулярности как кризисы, которые происходят один за другим, т. е. человечество будет жить на постингулярной стадии, и для каждого кризиса должны быть разработаны компенсационные механизмы”.

Важную роль в разработке таких компенсационных механизмов, на мой взгляд, мог бы сыграть формализм обратного 2го закона термодинамики — возможно, одного из важнейших “упрощений”, необходимых человечеству для понимания бесконечной сложности окружающего нас мира.

Открыт обратный 2й закон термодинамики

Комментариев нет:

Отправить комментарий